4.1. Fundamentos de las herramientas

El control y la reducción de los costes de calidad puede ir apoyado por un grupo de herramientas que, entre otras cosas, buscarán los mayores costes de calidad, para así poder tomar medidas para reducirlos, o las causas que los provocan, para poder eliminarlas; vigilando cómo se reducen y, en caso contrario, intentando averiguar los motivos que llevan a que no se reduzcan; y buscando oportunidades para reducir los costes.

El camino que nos lleva hacia la Calidad Total crea una nueva cultura, establece y mantiene un liderazgo, desarrolla al personal y lo hace trabajar en equipo, además de enfocar los esfuerzos de calidad total hacia el cliente y a planificar cada uno de los pasos para lograr la excelencia en sus operaciones. El hacer esto exige vencer obstáculos que se irán presentando a lo largo del camino. Estos obstáculos, traducidos en problemas, se deben resolver conforme se presentan. Para esto es necesario basarse en hechos, en el sentido común, en la experiencia o la audacia. De allí surge la necesidad de aplicar herramientas de medición, análisis y resolución de problemas y de grupo o creatividad de fácil comprensión.

Es conveniente realizar mediciones del proceso de mejora continua de la calidad, seleccionando en cada área o departamento los indicadores más adecuados; ya que de esta forma se pueden observar los progresos y establecer cursos de acción. Los indicadores son el mecanismo de diagnóstico y gestión que nos servirán de información para las herramientas de calidad y que ayudarán a saber que áreas son las problemáticas y, de éste modo, poder enfocar los esfuerzos y los recursos hacia ellas. Ahora bien, los indicadores no deben de servir para encontrar culpables de los fallos cometidos; el liderazgo y la participación de todo el personal favorecerán el uso correcto de los indicadores. (Popplell y Wilsmith, 1993 pp. 14 y ss.)

Para analizar las herramientas de gestión de calidad las hemos dividido en tres grupos: 1. Herramientas de medición y control. 2. Análisis y resolución de problemas y 3. De grupo y ayuda a la creatividad.

4.2 Herramientas de medición y control

En este grupo de hemos situado las herramientas que se caracterizan por dar información para poder observar y seleccionar los problemas y así, poder actuar de forma que se incremente el grado de acierto en la resolución de problemas para poder optimizar los costes. Hemos seleccionado 12 como las que más habitualmente son utilizadas en los sistemas de calidad estas son:

1) Diagrama de Pareto

2) Gráficos de control.

3) Hoja de recogida de datos.

4) Histograma.

5) Diagrama de correlación.

6) La función de pérdida de Taguchi.

7) Hoja de registro de tiempo o métodos de control de tiempo.

8) Estudios de precisión.

9) Encuestas o cuestionarios.

10) Quejas o sugerencias.

11) Análisis de tendencias.

12) Evaluación 360º.

4.2.1. Diagrama de Pareto

El Diagrama de Pareto es un histograma especial, en el cual las frecuencias de ciertos eventos aparecen ordenadas de mayor a menor (http://www.comadrid.es, 2002; Kume 1998b). Es una representación gráfica de los datos obtenidos sobre un problema generalmente los resultados que se suelen obtener indican que el 80% de los problemas están ocasionados por un 20% de causas que los provocan.

Según Alexander y Serfass (2002, pp. 1-11) y Harrigton (1990 p. 112) se utiliza para la selección del problema y para determinar los problemas más importantes. También se utiliza para la implementación de la solución para conseguir el mayor nivel de mejora con el menor esfuerzo posible, obteniendo un ahorro de costes considerable a partir de la planificación de la resolución de problemas ya que distingue entre los pocos elementos esenciales de los muchos secundarios.

Entre sus objetivos se encuentran (http://www.umh.es 2002):

Identificar las áreas prioritarias de intervención.·

· Atraer la atención de todos sobre dichas prioridades.

· Concentrar los recursos sobre éstas. Su aplicación sigue la siguiente secuencia:

1. Anotar las causas que provocan los problemas.

2. Ponderarlas según los incidentes o valor de éstos.

3. Ordenarlas de mayor a menor.

4. Obtener los porcentajes acumulados.

5. Representar los porcentajes relativos y los absolutos.

En el gráfico nº 2 y en la tabla nº 5, podemos ver un ejemplo de una empresa de confección de prendas de confección en piel, en donde se han encontrado que el número de devoluciones en el último mes se les ha disparado, y se plantean, en primer lugar, buscar los motivos que han producido estas devoluciones, para después atajar el problema; para ello han elegido un análisis por medio del diagrama de Pareto.

| Tabla nº5 Devoluciones por falta de calidad |

Und. |

% |

% |

| Defectos de forrería | 265 | 60,09% | 60,09% |

| Diferencia de tonos | 89 | 20,18% | 80,27% |

| Defectos por transporte | 45 | 10,20% | 90,48% |

| Defectos de piel | 23 | 5,22% | 95,69% |

| Defecto de patronaje | 8 | 1,81% | 97,51% |

| Otros | 4 | 0,91% | 98,41% |

| Defectos de medida | 3 | 0,68% | 99,09% |

| Rotura de piel | 2 | 0,45% | 99,55% |

| Defectos de planchado | 2 | 0,45% | 100,00% |

| Rotura de costuras | 0 | 0,00% | 100,00% |

| Total | 441 | 100,00% | |

| Ventas en unidades | 10000 | ||

| Devoluciones en unidades | 441 | 4,41% |

En este caso, vemos como el 80% de las devoluciones vienen motivadas por defectos de forrería y por diferencia de tonos en el color de las piezas de piel. Una vez detectadas las principales causas, se tomarían medidas para solucionarlas; en este caso se estudiarían en primer lugar las secciones de forrería y la de elección de tonos de piel.

Ahora bien, si nos fijamos en analizar las causas de estas devoluciones, no sólo midiendo las unidades sino valorando el coste que tendrán, teniendo en cuenta que puede que algunos de los defectos se podrán solucionar con algún reproceso, y en otros se tendrá que perder todo el producto; entonces los resultados del análisis serán diferentes. En este, caso como podemos ver en el gráfico nº 2b y la tabla nº 6, las prioridades, tomando en cuenta los costes, serán la diferencia de tonos y el transporte; quedando la sección de forrería en un porcentaje muy pequeño, a causa de que con un reproceso de poco coste se puede solucionar el problema.

| Tabla nº 6 Coste de las devoluciones por calidad | Unidades. |

% |

% |

Valor por unidad |

Euros |

% |

% |

| Diferencia de tonos | 89 | 20,18% | 80,27% | 155 | 13795 | 51,78% | 51,78% |

| Def. a causa del transp. | 45 | 10,20% | 90,48% | 155 | 6975 | 26,18% | 77,95% |

| Defectos de piel | 23 | 5,22% | 95,69% | 155 | 3565 | 13,38% | 91,33% |

| Defecto de patronaje | 8 | 1,81% | 97,51% | 155 | 1240 | 4,65% | 95,99% |

| Defectos de forrería | 265 | 60,09% | 60,09% | 2 | 530 | 1,99% | 97,98% |

| Defectos de medida | 3 | 0,68% | 99,09% | 155 | 465 | 1,75% | 99,72% |

| Rotura de piel | 2 | 0,45% | 99,55% | 25 | 50 | 0,19% | 99,91% |

| Otros | 4 | 0,91% | 98,41% | 5 | 20 | 0,08% | 99,98% |

| Defectos de planchado | 2 | 0,45% | 100,00% | 2 | 4 | 0,02% | 100,00% |

| Rotura de costuras | 0 | 0,00% | 100,00% | 2 | 0 | 0,00% | 100,00% |

| Total | 441 | 100,00% | 26.644 | 100,00% | |||

| Unid. | Euros | ||||||

| Ventas | 10000 | 1.550.000 | |||||

| Devoluciones 200 | 441 | 4,41% | 26644 | 1,72% |

Una vez analizados los dos casos, se tendrá que decidir por cuáles de las causas se empezará a tomar medidas para dar soluciones; ya que, si bien es verdad que si nos fijamos en el coste se tendrá en cuenta el análisis de costes, no hay que olvidar que, en cuanto a satisfacción del cliente, puede tener costes intangibles elevados por la pérdida de imagen de la marca. En este caso, tendremos que tomar como referencia el análisis por unidades, pues el valor de los costes implícitos que conlleva la satisfacción del cliente también pueden ser elevados, como incremento y/o disminución de la cuota de mercado, imagen de la empresa, introducción de nuevos modelos etc.

4.2.2. Gráficos de control.

Los gráficos de control son una herramienta para medir si el proceso se encuentra dentro de los límites deseados. Su aplicación más frecuente es en los procesos industriales, aunque como indican Peña y Prat (1990), son válidos para cualquier proceso en toda organización, por ejemplo: como indica Rosander (1985 pp. 10-4) esta herramienta es de uso muy generalizado en las instituciones financieras para el control de sus cuentas y actividades administrativas, vigilando las características que son más relevantes para ofrecer un servicio de calidad (Heskett, Sasser y Hart 1993). Son un diagrama, donde se van anotando los valores sucesivos de la característica de calidad que se está controlando los datos se registran durante el funcionamiento y a medida que se obtienen (Barca 2000, pp. 1-6). Permiten un control visual del proceso (Ozeki y Asaka (1992), y suministra una base para la acción que servirá para que los responsables de la toma de decisiones actúen a partir de la información que revela dicho gráfico (Charbonneau y Webster, 1983 p. 74).

Los gráficos de control se utilizan para conocer qué parte de variabilidad de un proceso es debida a variaciones aleatorias y qué parte a la existencia de sucesos o acciones individuales. Nos permitirá conocer si un proceso es estable o no. Los límites calculados estadísticamente nos indican el rango de variación de los promedios de datos individuales tomados del proceso, cuando esta variación es consecuencia sólo de la aleatoriedad del proceso. Por lo tanto, un proceso será estable cuando repita por sí mismo los resultados durante un período largo de tiempo. En este caso, los resultados seguirán una distribución estadística normal (Kume 1985b). Cuando los valores que aparecen en el gráfico de control se sitúan dentro de los límites de control y, sin ninguna disposición particular, las diferencias entre los distintos valores se deben a motivos de aleatoriedad. Las causas que dan lugar a éste tipo de disposición se denominan causas comunes. Sólo serán significativos los puntos fuera de los límites de control a la hora de buscar motivaciones y causas para estos resultados concretos. Éstas serán las causas especiales, cuyo origen no descansa en el propio sistema sino en razones ajenas al mismo. En la figura 9, podemos comprobar dos procesos.

No se debe de confundir los límites de control con el que los productos cumplan las especificaciones, ya que puede ser que los requisitos de las especificaciones estén dentro de los límites de control o fuera. El que se esté en los límites de control lo que nos asegura es que el proceso es estable, por lo que los fallos no son asignables a causas especiales sino a causas comunes (Ouchi, 1979 pp. 833-848). El que el nivel de tolerancia de las especificaciones esté dentro del control (especificaciones 1) o no (especificaciones 2) dependerá de las exigencias que tengamos en cuanto a tolerancias. Así, vemos en la figura B que el proceso no es estable, ya que los limites de control en 3 sigma no se cumplen. Como podemos observar, la curva de la normal está desplazada hacia la derecha, por lo que tendremos causas especiales que se deben de corregir.

Las causas comunes también se pueden mejorar, pero en este caso será perfeccionando el proceso o las máquinas que están implicados en él. Las causas especiales estarán motivadas por otras causas: mal reglaje, fallos de operador etc. (Galbraith, 1973 p 65). Fayol (inc. en Pinillos 1995 pp. 281-282).

4.2.3. Hoja de recogida de datos.

La hoja de recogida de datos recopila la información necesaria para poder responder a las preguntas que se nos puedan plantear (Ishikawa, 1982 p. 29). Lo esencial de los datos es que el propósito esté claro y que los datos reflejen la verdad, siendo fáciles de recoger y de usar (Mohr y Mohr, 1983). Entre las funciones que se pueden utilizar podemos destacar las siguientes (Kume, 1985b p. 21-30):

· Distribución de variables de los artículos producidos.

· Clasificación de artículos defectuosos.

· Localización de los defectos de las piezas.

· Causas de los defectos.

· Verificación de chequeo o tareas de mantenimiento.

Siempre haciendo fácil la recogida de datos y realizándola de forma que los datos puedan ser usados fácilmente y analizados automáticamente.

Una vez fijadas las razones para recoger los datos, se deben de analizar las siguientes cuestiones (Kume, 1985b pp. 21-30):

· Cómo se deben de recoger los datos y con qué tipo de documento se realizará.

· Cómo se debe utilizar la información recogida.

· Cómo se analizará.

· Quién debe ser el encargado de la recogida de los datos.

· Qué frecuencia se debe de realizar.

· Y dónde se realizará.

La recogida de los datos puede ser en ocasiones muy costosa Douglas D. Danforth, (1986, p. 17) presidente de Westinghouse Eléctric afirmó que el 60% de sus empleados eran administrativos ocupados en la información. Y que los costes administrativos eran más de la mitad de los costes totales de calidad de la compañía. Para la optimización de la recogida de datos Harrinton (1990, p. 82-84) propone que la recogida de datos se realice por un auditor experimentado y en una muestra aleatoria de las actividades, de las personas y de los equipos de las áreas que se deben de observar. Según Harrinton (1990) entre las ventajas que tiene este sistema están:

· Datos más exactos.

· Menos variación de los datos.

· Menos distracciones de los empleados.

· Menos papeleo de los empleados.

· Informes menos sesgados.

· Menor tiempo para analizar los datos.

Entre las desventajas destaca las siguientes:

Es necesario un auditor experimentado y bien preparado.·

· En algunas ocasiones las impresiones que se obtienen no reflejan el estado real del trabajo.

· Puede ser que los empleados reacciones de forma diferente cuado se ven observados por el auditor, proporcionando datos que no son representativos del proceso normal.

En todas las empresas la recogida de datos es fundamental, lo que pretende esta herramienta es organizar y optimizar esta recogida para sacar el mayor provecho posible.

4.2.4. Histograma

El histograma es una representación gráfica de la variación de un conjunto de datos, que indica cómo se distribuyen los valores de una o varias características (variables) de los elementos de una muestra o población, obtenidos mediante un determinado proceso, mostrando el grado de variación del mismo. Se utiliza para la ordenación de datos y hechos que son utilizados en la medición de datos para poder seleccionar los problemas para su resolución y para la mejora de la calidad (Kume 1985b).

El histograma es como una radiografía del proceso en un momento determinado y puede suministrarnos varias características como:

Media de los valores del mismo (centrado).·

· Distribución de las medidas (distribución).

· Tipo de distribución (forma).

· Visión clara y efectiva de la variabilidad del sistema.

· Mostrar el resultado de un cambio de sistema.

· Identificar anormalidades examinando la forma.

· Comparar la variabilidad con los límites de especificación.

Un ejemplo de este tipo de herramientas sería un gráfico mostrando la evolución de las no conformidades detectadas en la organización durante un periodo de tiempo determinado.

4.2.5. Diagrama de correlación.

El diagrama de correlación es una representación gráfica en un eje de coordenadas de los datos que se recogen sobre dos variables para poder estudiar si existe relación de causa efecto entre ellas (Kume 1985b).

Se utiliza para comprender si se encuentran vinculadas entre sí dos magnitudes y en qué medida. Sirve para verificar causas reales, definir y medir relaciones existentes entre dos variables. Se instrumentaliza en cuatro fases (Kume 1985b):

| · Recogida de datos. | · Interpretación. |

| · Representación de datos. | · Medición de la correlación. |

Puede ser de cuatro tipos (ver en la figura nº 10).

· De correlación positiva: al aumentar el valor de una variable, aumenta la de la otra.

· De correlación negativa: cuando aumenta una variable la otra disminuye.

· De correlación no lineal: la relación estadística entre las dos variables no está descrita por una recta.

· Sin correlación.

Esta herramienta es adecuada para sacar conclusiones de determinadas relaciones del tipo de causa–efecto, como p. e. incremento del presupuesto en publicidad e incremento de ventas.

4.2.6. La función de pérdida de Taguchi.

En los años ochenta el Dr. Taguchi (1979, 1986) desarrolló en Japón un método para calcular las pérdidas de un producto de mala calidad. Su definición de calidad es: (evitar) la pérdida que un producto causa después de terminarlo. La Función de Pérdida la define como una combinación de métodos estadísticos y de ingeniería para conseguir rápidas mejoras en costes y calidad, mediante la optimización del diseño de los productos y sus procesos de fabricación (www.calidad.com, www.calidad.com.mx, www.hispacal.com, www.egr.msu.edu, www.asq.org).

Para Taguchi la pérdida incluye (Taguchi, 1979, 1986):

· los costes incurridos por no cumplir el producto con las expectativas del cliente,

· los costes por no cumplir el producto con las características de funcionamiento, y

· los costes causados por los efectos peligrosos secundarios causados por el producto.

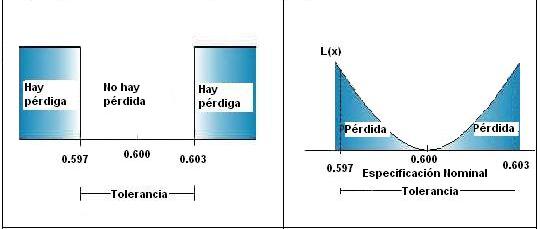

Muchas empresas quedan satisfechas cuando las características de calidad de un producto quedan dentro de las especificaciones. Se piensa que mientras estamos dentro de la tolerancia, no existen pérdidas asociadas. Supongamos, p. e. que las especificaciones de un determinado producto son 0,600 ± 0,003 (Ver figura nº 11). Taguchi define en su Función de Pérdida, como las características de un producto, a medida que se alejan de su objetivo, incrementan las pérdidas de acuerdo a una función parabólica. Según Taguchi, mientras menor sea la variación con respecto al valor objetivo, mejor será la calidad. La pérdida aumenta, como función cuadrática, cuando uno se aleja más del valor objetivo. La Función de Pérdida está representada por la siguiente ecuación: L(x) = k(x-T)2, donde L(x) es la función de pérdida, x es cualquier valor de la característica de la calidad, T el valor deseado y k una constante en relación con el valor del coste.

| Figura Número 11 Función de pérdida de Taguchi | |

|

|

| Modelo tradicional |

función de pérdida de Taguchi |

Ésta función es una herramienta para la ingeniería. El punto clave de su aplicación son los costes, que es necesario reducirlos a los mínimos (Jiménez y Nevado 2000 p. 270), mediante un proceso de optimización, unido a una evolución de la fabricación, la justificación económica es la función de pérdida o como se conoce con su nombre en ingles Quality loss Function (QLF). Así, puede ser utilizado para determinar el coste de insatisfacción ocasionado por la producción de unidades que presentan desviaciones respecto al valor objetivo.

4.2.7. Hoja de registro de tiempo o métodos de control de tiempo

Se trata simplemente de anotar en unas hojas de registro los datos de los tiempos de las distintas fases de los procesos, para compararlos con los parámetros establecidos. Sirve para el cálculo de tiempo empleado en la realización de tareas.

Uno de los factores más importantes es el cálculo del precio del incumplimiento (Jiménez y Nevado, 2000). Las hojas de registro de tiempos facilitan esta labor. Como componentes de este factor se puede incorporar: el tiempo empleado por el departamento de calidad en detectar y corregir errores de registro y de codificación contable, el tiempo para la realización de los informes de seguridad, el tiempo de cualquier proceso de fabricación, el tiempo muerto en la cadena de producción, etc.

4.2.8. Estudios de precisión.

Se trata de la calibración de los instrumentos que se utilizan para la medición y comprobación de los productos fabricados.

Los estudios de precisión pueden permitir determinar los defectos e identificarlos correctamente de manera que nos muestre los costes de calidad que puede acarrear, separando las unidades defectuosas de las buenas, multiplicando el costes de las defectuosas por su valor y extrapolando su coste para calcular los costes de calidad (Jiménez y Nevado 2000). Los sistemas de gestión de la calidad, deben incluir los procedimientos técnicos necesarios para garantizar que las decisiones de aceptación y rechazo de productos y procesos sean correctas, tras considerar la incertidumbre de los equipos de medida empleados.

Para que los usuarios puedan establecer procedimientos de aseguramiento de la calidad de sus mediciones, existen algunas normas ISO que es posible aplicar, algunas de ellas publicadas en español como las normas UNE. Entre éstas destacan la serie ISO 8322, partes 1 a 10, que presenta procedimientos para determinar la exactitud de utilización de los instrumentos de medida..

4.2.9. Encuestas o cuestionarios

La encuesta es un método de recogida de información mediante preguntas realizadas de distintas formas a las personas que disponen de la información deseada. Herramienta superconocida que se puede utilizar para gran variedad de estudios, entre los cuales pueden ser para estimar los costes intangibles y satisfacción de los clientes (Jiménez y Nevado 2000). La información es un elemento esencial para la toma de decisiones, y una buena información permite a los directores de empresas saber, prever, seguir y controlar (Ortega 1994 p. 69).

Para el lanzamiento de una encuesta se debe de confeccionar primero el cuestionario, para lo cual se debe de plantear una serie de temas para encarar el problema, temas como (Lebret 1961):

· Orden del cuestionario.

· Tipos de preguntas.

· Lenguaje que se debe de utilizar.

· Tiempo de duración máximo.

· Presentación del cuestionario al entrevistado.

· Trato de la información que se va a obtener.

Otra de las cuestiones importantes en el diseño del cuestionario es como va a ser la encuesta, ya que pueden ser de tres tipos, personal, postal y telefónica, pasamos a mostrar los principales ventajas e inconvenientes de cada una (Ginhan y Moore, 1960; Lebret, 1961; Ortega, 1994) (ver tablas nº 7, 8 y 9).

Encuesta personal. Consiste en una entrevista personal entre dos personas, a iniciativa del entrevistador, para obtener información del entrevistado sobre unos objetivos determinados.

| Tabla nº 7 ventajas e inconvenientes de la encuesta personal | |

| Ventajas: | Inconvenientes: |

| Elevado índice de respuestas. | Es un método muy caro. |

| No hay influencia al entrevistado. | Es lento. |

| Se conoce con certeza la persona que realiza la encuesta. | Cualificación de los entrevistadores sobre al tema de la investigación. |

| Se pueden aclarar las dudas de interpretación de cualquier pregunta. | Es posible que el entrevistador distorsione parte de los resultados, influyendo al entrevistado influyendo al entrevistado. |

| Pueden obtenerse datos secundarios del entrevistado respecto al objetivo. | |

Encuesta postal. La recogida de información se realiza mediante un cuestionario que se envía y devuelve por correo.

| Tabla nº 8: ventajas e inconvenientes de la encuesta postal | |

| Ventajas: | Inconvenientes: |

| Es un método más económico. | Bajo índice de respuestas en general. |

| Flexibilidad en el tiempo para el entrevistado. | No se conoce con certeza la identidad de la persona que realiza la encuesta. |

| Puede llegar a muchas personas, por lejanas que se encuentren. | Pueden existir influencias de otras personas. |

| Interpretación de las algunas preguntas. | |

| Más rápido en el tiempo de desarrollo de la investigación. | Pueden haber distorsiones por las encuestas que no se devuelven cumplimentadas. |

| Elimina las influencias del entrevistador. | El cuestionario debe de ser más reducido. |

| No se pueden obtener datos secundarios | |

| Muchas veces es difícil de conocer el censo de las personas u organizaciones a quien va dirigida la encuesta. | |

Encuesta telefónica:

| Tabla nº 9 ventajas e inconvenientes de la encuesta telefónica. | |

| Ventajas: | Inconvenientes: |

| Es un sistema relativamente económico. | Brevedad de la entrevista. |

| Es rápido. | |

| Permite entrevistar personas muy ocupadas. | No se pueden obtener datos secundarios. |

| Existe una inclinación mayor a responder por teléfono. | |

| No existen deformaciones de las preguntas por su lectura y falta de interpretación correcta. | |

| Mayor sinceridad en algunos casos. | Desconfianza del entrevistado. |

| Elevado índice de respuestas. | |

4.2.10. Quejas o sugerencias.

Son unas hojas que están a disposición de los clientes para que manifiesten su quejas y su falta de satisfacción de los productos y o servicios adquiridos, de tal forma que lleguen a la dirección de la organización. Se trata de que el cliente que no esté satisfecho por un determinado producto, o por la prestación de un servicio, rellene un formulario en donde manifieste las causas de su disconformidad.

Aunque, es una de las herramientas más implantada en todas las organizaciones, e incluso, es obligatorio su uso por parte de las autoridades para que la tengan al servicio de los clientes; sin embargo, no es una herramienta muy eficaz, ya que la mayor parte de clientes no se molestan en rellenar el formulario describiendo las causas que no les ha satisfecho el producto o servicio, sino más bien no compran el producto o no demandan más el servicio.

Hay algunas técnicas de incentivar esta herramienta como: el estimular económicamente a los clientes que las presente, líneas 900, etc., de este modo la empresa obtiene datos de fallos externos para poder corregirlos.

El conocimiento de las quejas de los clientes interesa entre otras por las siguientes razones (Larrea, 1992, pp. 225-241):

Estabiliza la relación quejas/fallos. El conocimiento del número de quejas permite obtener una idea global del nivel de fallos incurridos.·

· Permite conocer y corregir sus causas.

Esta herramienta se debe de incentivar su utilización ya que la lealtad de recompra de los que se quejan es sensiblemente superior a la de los insatisfechos no quejosos. Ya que el cliente insatisfecho puede recuperarse si se le reconoce su queja, hay una acción inmediata y no se le cicatea en la restitución. Un defecto de calidad es una oportunidad para convertir a la persona insatisfecha en el centro de atención de la organización por unos momentos. Además, puede servir para poner en marcha la creatividad para rediseñar el producto o servicio, y resolver el motivo de la queja sorprendiendo al cliente y de esta forma fidelizándolo. La quejas se deben de registrar todas, así como sus soluciones, de forma centralizada, formalizada y completa, de esta forma se enriquecerá la memoria corporativa.

4.2.11. Análisis de tendencias

Consiste en confeccionar gráficos referentes a información diversa de la organización y comparar los niveles actuales con los del pasado (Jiménez Nevado 2000). Su utilización muestra de forma gráfica una visualización general de las tendencias de las variables que se estudian. Los costes de cada uno de los grupos se pueden separar por meses y cuantificar en euros tanto en valores absolutos como relativos como porcentajes respecto a variables directamente implicadas.

Como ejemplo de esta herramientas podemos citar la evolución de las ventas de la empresa, o de cada uno de los productos. Esta herramienta al estudiar a lo largo del tiempo la evolución de las ventas de un producto nos mostrara el ciclo de vida de mismo.

4.2.12. Evaluación 360º.

Se trata de conseguir información de una o de un grupo de personas, pero de forma extensiva, para poder determinar diferentes posibilidades de formación, de corrección de errores etc. Esta herramienta es utilizada cada vez más por las organizaciones modernas. Los principales usos que se da a la evaluación de 360º son las siguientes (IESE 2002):

- Medir la eficacia del personal.

- Medir las competencias (conductas).

- Diseñar programas de desarrollo.

La evaluación de 360º pretende dar a los empleados una perspectiva de su cometido, lo más adecuada posible, al obtener aportes desde todos los ángulos: supervisores, compañeros, subordinados, etc. Si bien, en sus inicios esta herramienta sólo se aplicaba para fines de desarrollo, actualmente está utilizándose para medir la eficacia, para medir competencias y otras aplicaciones administrativas.

El propósito de aplicar la evaluación de 360º es darle al empleado la retroalimentación necesaria para tomar las medidas para mejorar su cometido, su comportamiento o ambos, y dar a la gerencia la información necesaria para tomar decisiones en el futuro. Para que tenga éxito, se requiere el compromiso de la alta dirección y una formación adecuada de todos los involucrados en el proceso. En especial, es clave que el jefe del evaluado actúe no sólo como juez, sino también como formador. La evaluación de 360º tiene las siguientes ventajas e inconvenientes (IESE, 2000):

| Tabla nº 10 ventajas e inconvenientes de la evaluación de 360º | |

| Ventajas: | Inconvenientes: |

| El sistema es más amplio, en el sentido de que las respuestas se recolectan desde varias perspectivas. | El sistema es más complejo, en términos administrativos, al combinar todas las respuestas. |

| La calidad de la información es mejor (la calidad de quienes responden es más importante que la cantidad). | La retroalimentación puede ser intimidatoria y provocar resentimientos si el empleado siente que quienes respondieron se confabularon. |

| Complementa las iniciativas de administración de calidad total, al hacer énfasis en los clientes internos, externos, y en los equipos. | Quizá haya opiniones en conflicto, aunque puedan ser precisas desde los respectivos puntos de vista. |

| Puede reducir el sesgo y los prejuicios, ya que la retroinformación procede de más personas, no sólo de una. | Para funcionar con eficacia, el sistema requiere capacitación. |

| La retroalimentación de los compañeros y los demás podrá incentivar el desarrollo del empleado. | Los empleados pueden engañar al sistema dando evaluaciones no válidas. |

4.3. Herramientas para el análisis y resolución de problemas.

En la clasificación de este grupo de herramientas hemos escogido las herramientas que se utilizan para analizar y resolver los problemas una vez estos ya están identificados y tenemos información de su importancia, información tanto de su envergadura, de los costes de ocasiona etc. esta información se habrá obtenido mediante la utilización de las herramientas estudiadas anteriormente (las herramientas de medición y control).

4.3.1 Diagrama de flujo.

El Diagrama de flujo es una representación gráfica utilizada para mostrar la secuencia de pasos que se realizan para obtener un cierto resultado. Éste puede ser un proceso, un servicio, o bien una combinación de ambos (Calidad.com; 2002). Consiste en la representación o descripción básica de un problema, que nos ayudará a entender el funcionamiento de un proceso antes de tomar una solución. Es una herramienta útil para examinar cómo se relacionan entre sí las distintas fases de un proceso.

En el diagrama de flujo se utilizan símbolos fácilmente identificables para representar el tipo de proceso desarrollado en cada fase (en la figura 12 podemos ver un ejemplo). Se utiliza cuando se necesita identificar el camino real que un producto o servicio sigue, a fin de identificar desviaciones. Los diagramas de flujo procuran una visión gráfica de los pasos requeridos en la obtención de un producto o en la prestación de un servicio, e identifican aquellos puntos de proceso que son críticos para el éxito del producto o servicio (Shostack 1987 pp. 45-48).

Esta herramienta permite una visualización completa del proceso y de sus posibles problemas, dando una imagen de conjunto que permite un análisis mucho más eficaz.

4.3.2. Diagrama causa efecto o Ishikawa (espina de pescado o árbol de causas)

El diagrama de causa–efecto o Isikawa (tambien conocido por otros nombres como espina de pescado, o árbol de causas) es una representación gráfica de las relaciones lógicas que existen entre las causas que producen el efecto definido. Permite visualizar, en una sola figura, todas las causas asociadas a una disfunción y sus posibles relaciones y permite analizar el encadenamiento de los acontecimientos (Kume 1985b).

Se utiliza entre otras motivos para: establecer un proceso por primera vez, aumentar la eficacia de un proceso, mejorar un bien o servicio, reducir o eliminar las deficiencias, modificar procedimientos o métodos de trabajo, identificar puntos débiles, guiar discusiones, dar soporte didáctico etc.

En la figura nº 13 podemos ver un ejemplo en donde el problema que tenemos es índice elevado de impagados.

|

Para su aplicaciónse debe precisar el efecto de análisis, respondiendo a preguntas tales como: ¿quién?, ¿cómo?, ¿cuándo?, ¿dónde? y ¿cuánto? de diferentes problemas, tales como: ¿qué problema/defecto/ineficiencia tenemos?, ¿dónde se sitúa?, ¿quién es la persona o grupo implicado en él?, ¿cuándo ha aparecido por primera vez?, etc. Para encontrar las posibles causas se puede utilizar el brainstorming. Posteriormente se deben de subdividir las causas en familias a través de elementos comunes, siguiendo alguno de los siguientes criterios (Kume 1985b):

· Las 5M. Se consideran 5 familias (métodos, máquinas, materiales, mano de obra y medio ambiente).

· Fases del proceso: relaciona las causas con cada fase del proceso y se reparten las causas probables.

· Causas encadenadas: se identifican cuáles, entre las causas probables consideradas, constituyen "racimos de causas".

Esta herramienta permite combinar varias herramientas y obtener unos análisis mucho más pormenorizados de los distintos problemas, así, por ejemplo en cada una de las familias de las causas se puede utilizar un análisis de Pareto para cuantificar la importancia de las mismas.

4.3.3. Matriz de criterios

La matriz de criterios consiste en una matriz de doble entrada, por medio de la cual se obtiene la solución más idónea al problema que se quiere resolver. Sirve para reducir la subjetividad cuando se desea determinar cuál de las soluciones previstas se ajusta más a los criterios prefijados. En las filas se sitúan las soluciones que tenemos previstas y en las columnas los criterios bajo los cuales nos queremos regir. Entre estos criterios podemos citar algunos más generales tales: como: rapidez, fiabilidad, sencillez, coste, efectividad, etc. Lo podemos ver en el ejemplo de la figura 14.

Esta herramienta es la que hemos utilizado para decidir que medio utilizábamos para hacer llegar la encuesta a las empresas que hemos utilizado para realizar el trabajo empírico, una vez obtenido las ponderaciones y aplicadas las mismas se decidió realizarla por correo.

4.3.4. DAFO

El análisis DAFO es un acrónimo cuyas letras significan: D debilidades (p. e. falta de comunicación entre áreas de una misma empresa), la A amenazas externas a la organización (p.e., la situación político-económica de un país) la F fortalezas intrínsecas de la organización (p. e., una política de mercado clara, una filosofía de trabajo propia de la empresa) y la O oportunidades externas, (p. e. del mercado).

Fue introducida en 1982 por Heinz Weihrich (1982, pp. 54-66). Esta considerado como una valiosa herramienta para formular la estrategia de unidad de negocio (Garcia, 1987; p. 439). Koontz y Weihrich, (1991, p. 98) lo definen como: "una estructura conceptual para el análisis sistemático, que facilita la comparación de las amenazas y oportunidades externas con las fuerzas y debilidades internas de la organización." Su confección requiere la determinación de los puntos fuertes y débiles de la empresa y de las oportunidades y amenazas del entorno, estos aspectos se pueden agrupar en una doble clasificación: factores externos y factores internos (Benavides, 1998, pp. 342-345).

Los factores externos afectan a la empresa en su funcionamiento. Se trata de identificar los factores exógenos que configuran el entorno de la organización y que les pueden afectar como la estructura del sector que según Porter (1982 pp 10–14; 1987 25-45) está compuesta por cinco fuerzas: el poder de negociación de los clientes, el poder de negociación de los proveedores, la amenaza de nuevos entrantes al sector, la amenaza de productos sustitutos producidos por otros sectores y la rivalidad entre los competidores del sector. Estas fuerzas y el gobierno constituyen el micro entorno de la empresa, el cual está, a su vez, afectado por las fuerzas y tendencias del macro entorno y del ambiente internacional (Austin 1993).

Los factores internos identifican las situaciones o factores endógenos de la organización que afecten al logro de sus objetivos.

Para realizar el análisis DAFO se deben de tener en cuenta aspectos tales como: la misión de la empresa, las áreas clave del entorno y las áreas clave internas (ver figura nº 15).

Figura 15 - Análisis DAFO

Esta herramienta nos permite centrar las coordenadas básicas del negocio, conocer con detalles a los competidores, las condiciones de crecimiento del mercado en donde se actúa, detectar cambios en el entorno y en los consumidores, etc. Así, como conocer en profundidad la empresa, en aspectos como: las interreleciones que existen, los recursos humanos que se dispones, la tecnología que se dispone, las redes de comunicación formales o informales etc.

Como criticas a esta herramienta podemos citar la que hacen los autores Hamel y Prahald (1989) en donde consideran que el análisis DAFO es una foto instantánea que se le toma a la empresa que no permite ver su dinámica competitiva por lo que el análisis DAFO no indica a que velocidad van los competidores y cuál es su dirección a largo plazo.

4.3.5. Despliegue de la función de calidad, QFD.

El despliegue de la función de calidad (Quality, Function, Deployment) (QFD) es una herramienta que ayuda al equipo interfuncional a organizar y relacionar la información obtenida durante las etapas del proceso de planificación (Hauser y Clausing, 1989, pp. 31-43). QFD es una metodología de planificación que introduce el control de calidad en la etapa del diseño y desarrollo de un producto o servicio. Es un mecanismo formal para asegurar que la "voz del consumidor" sea escuchada y tomada en cuenta en todas las etapas del desarrollo del producto o servicio. El QFD colabora en el equipo interfuncional de marketing, I+D (investigación y desarrollo), fabricación y ventas, ayudándolos a centrarse en el desarrollo de productos. Brinda procedimientos y procesos para mejorar la comunicación centrándose en el lenguaje del cliente. El significado de cada una de las palabras que forman su nombre son:

· Quality: Calidad, características, atributos o cualidades que los clientes requieren de cierto producto y/o servicio.

· Function: Función, actividades que se requiere instrumentar para lograr las características deseadas.

· Deployment: Desarrollo, integración o sistematización de las actividades que ayudarán al logro de los requerimientos del producto o servicio.

Yoji Akao (1993) desarrolló el Despliegue de la función de calidad, en el astillero de la Mitsubishi en Kobe. La QFD tiene como objetivo transformar los requerimientos o necesidades de los clientes en acciones para satisfacerlos (NASA 2002; Pola, y Palom,1995).

Se desarrolla en cuatro fases que son las siguientes: (ver tabla 11 )

| Tabla 11 desarrollo del QFD | |

| Fase | Descripción |

| 1. Planificación del producto | Se identifican los requerimientos del consumidor (voz del cliente). |

| 2. Diseño del producto | Se establecen las características que deben tener los componentes del producto o servicio. |

| 3. Diseño del proceso | Se estructuran las actividades necesarias para lograr los componentes establecidos. |

| 4. Preparación de la producción | Se determina el programa de elaboración de cada uno de los componentes y la integración de los mismos. |

Don P. Clausing (1989, p.1) señaló que el QFD involucra dos conceptos primordialmente: el formato y el comportamiento organizativo. En el formato se establece que existe una estructura de trabajo definida además de las herramientas que apoyan la generación de información y la documentación de la misma sirve de apoyo para estructurar la información obtenida. El comportamiento organizacional menciona que existe un énfasis total en el trabajo de equipos multidisciplinarios o multifuncionales, con representantes de diferentes áreas de la empresa, y que se utiliza un estilo de toma de decisiones que se basa en el consenso.

La analogía más usada para explicar como está estructurado el QFD es una casa. La figura 16 muestra como se reúne una matriz QFD básica. La pared de la casa en el costado izquierdo, componente 1, es el input del cliente. Esta es la etapa en el proceso en la que de determinan los requerimientos del cliente relacionados con el producto. El techo interior de la casa es el componente 2 y se utiliza para satisfacer los requisitos de los clientes para lo cual la organización trabaja ciertas especificaciones de cometido, y pide a sus proveedores que hagan lo mismo.

La pared derecha de la casa, componente 3, es la matriz de planificación, es el componente que se usa para traducir los requerimientos del cliente en planes para satisfacerlos o sobrepasarlos. Se marcan los requisitos del cliente en una matriz y los procesos de desarrollo en otra, jerarquizando los requisitos del cliente y tomando decisiones relacionadas para las mejoras necesarias en los procesos de manufactura. El centro de la casa, componente 4, es donde se convierten los requisitos del cliente en términos o expresiones concretas, p.e. si un cliente quiere que la vida operativa (útil) de tu producto sea de doce meses en lugar de seis, ¿qué significa esto en términos de los materiales empleados?, ¿diseño?, ¿procesos? etc.

El fondo o base de la casa, componente 5, es donde se jerarquizan los requisitos del proceso que son críticos. ¿Qué requisito es más importante en términos de satisfacer o sobrepasar los requisitos del cliente?, ¿cuál es el siguiente, y así sucesivamente?.

El techo exterior de la casa, componente 6, es donde se identifican las interrelaciones. Estas interrelaciones tienen que ver con los requisitos de la organización. En vista de los requisitos de su cliente y de sus capacidades, ¿qué es lo mejor que puede hacer la organización? Este tipo de pregunta se contesta aquí.

En un estudio sobre el Despliegue de la Función de Calidad realizado en los Estados Unidos (Griffin 1992 pp 171-187) sugiere que el mayor impacto del QFD ha sido una mejora en el proceso de desarrollo de productos, para su eficacia en el largo plazo.

Los sistemas de calidad necesitan que los distintos departamentos de las empresas cooperen entre sí, porque es imprescindible la relación y cooperación entre todos los departamentos de las empresas. El QFD mejora la comunicación, además mejora el éxito del mercado, asegurando que cada una de funciones de la empresa se oriente a brindar beneficios al consumidor.

4.4. Herramientas de grupo y de ayuda a la creatividad

La obtención de ideas de calidad es un tema de máxima importancia. Se necesitan ideas para generar nuevos productos, para resolver problemas, para tomar decisiones acertadas....; para ello, en muchas ocasiones se debe de recurrir a la creatividad y apoyarse en herramientas que faciliten su obtención (Escorsa y Valls 1997 p. 91).

La creatividad se puede definir como el proceso mental que ayuda a generar ideas con un conjunto de técnicas y metodologías susceptibles de estimular e incrementar la capacidad innata de crear (Majaro, 1992). Otros autores como Diaz Carrera (1991) opinan que la creatividad equivale a la capacidad de generar ideas y se mide por la fluidez, la flexibilidad y originalidad de éstas. Para Barceló (1984) la creatividad es buscar nuevas soluciones a viejos problemas mediante métodos lógicos. Podríamos resumir diciendo que la creatividad es la habilidad para abandonar las vías estructuradas y las maneras de pensar habituales y reunir secciones de conocimiento y experiencia no conectados previamente para llegar a la idea que permita solucionar un determinado problema. Por lo tanto las empresas deben de seleccionar y aprovechar las ideas creativas, tanto internas como externas, y gestionarlas de forma sistemática, pues estas ideas son la materia prima para la innovación y la solución de problemas.

Una vez vistas diferentes definiciones de creatividad vamos a ver determinadas herramientas que nos pueden ayudar a estimular la creatividad.

4.4.1. La lluvia o tormenta de ideas

La lluvia de ideas o como más se le conoce, el brainstorming, es una técnica mediante la cual un grupo de personas intenta encontrar soluciones a un problema específico, generando ideas de forma espontánea (Escorsa y Valls, 1998, pp. 89-103).

En 1938 el psicólogo norteamericano Alex Osborn (1948, 1965) fue uno de los pioneros de los métodos para la generación de ideas creativas al poner a punto la técnica del brainstorming (literalmente tormenta de cerebros) (Robson, 1982).

El brainstorming o tormenta de ideas se ha perfeccionado y actualmente se concibe como una técnica para generar ideas, en la cual un grupo de personas van exponiendo sus ideas, a medida que van surgiendo, de modo que cada cual tiene la oportunidad de ir perfeccionando las ideas de otros. Se desarrolla mediante reuniones en donde no se distinguen ni critican las ideas que van

apareciendo. Todo está permitido, incluso las ideas más absurdas y desbaratadas que fluyen libremente. Esta atmósfera relajada e informal, libre de todo espíritu crítico, es básica. (Majaro 1992). Los participantes no se han de sentir nunca cohibidos. La evaluación de las ideas generadas se hace posteriormente. De esta forma pone en marcha el flujo de ideas y proporciona al grupo confianza en sí mismo.

El Brainstorming se desarrolla en cinco fases (González Meriño, 2000 pp 8-14), (Richards Tudor, Et al 1988 ):

1) Preparación: creación de las condiciones para el desarrollo de la reunión y provisión de documentación.

2) Calentamiento: desinhibición y relajamiento del grupo antes de pasar a la sesión oficial de generación de ideas.

3) Se presenta el tema y se marcan los límites del mismo, de forma que todos los participantes tengan una visión exacta del objetivo de la reunión.

4) Cada uno de los participantes da una idea, la cual es registrada.

5) Evaluación: toma de decisiones por expertos o con el grupo, basándose en técnicas de consenso.

La tormenta de ideas se desarrolla básicamente por tres métodos (Sociedad Latinoamericana de la Calidad 2002).

1 No estructurado (flujo libre) se trata de escoger a un miembro que apunte las ideas que van surgiendo. Se debe de fomentar la creatividad, por ejemplo, construyendo sobre las ideas de otros.

2 Estructurada. Igual que la anterior, la diferencia consiste en que cada miembro del equipo presenta sus ideas de forma ordenada (por turno).

3 Silenciosa. En este caso, los participantes piensan las ideas y las escriben en un papel. Posteriormente se intercambian las ideas escritas y se pueden añadir más ideas al papel del otro miembro del equipo.

Las ventajas de cada uno de éstos métodos los podemos ver en la Tabla 12.

| Tabla nº 12 Ventajas y desventajas de los métodos de brainstorming | |

| Estructurado o rueda libre | |

| Ventajas | Desventajas |

| · Muy espontáneo. | · Individuos fuertes pueden dominar la sesión. |

| · Tiende a ser creativo. | · Sobrevive la confusión. |

| · Facilita contribuir a las ideas de otros. | · Pueden perderse ideas cuando hablan demasiados a la vez. |

| No estructurado o por turno | |

| · Es más difícil que un individuo | · Se hace difícil aguardar por el turno. |

| · Es más difícil que un individuo domine. | · Se hace difícil aguardar por el turno. |

| · Las discusiones tienden a ser más centradas. | · Hay cierta pérdida de energía. |

| · Se alienta a todo el mundo a que participe. | · Resistencia a dar una opinión. |

| · No es tan fácil trabajar sobre las ideas de otros. | |

| Silencioso o método de la "tira de papel" | |

| · El anonimato permite que tópicos delicados afloren. | · Es muy lento. |

| · Se puede aplicar en grupos muy numerosos. | · Puede ser que algunas ideas sean ilegibles e incomprensibles. |

| · No es necesario hablar. | · No es posible contribuir a la ideas de otros. |

| · Es difícil aclarar ideas. | |

Esta herramienta es de las más utilizadas actualmente dentro de los sistemas de calidad, potenciando la colaboración entre los miembros de la organización.

4.4.2. El benchmarking

El benchmarking cuya traducción en español podría ser colaboración entre diferentes grupos para la mejora del sistema, es un proceso estratégico y analítico que consiste en identificar a los competidores o compañías, que obtienen las mejores prácticas en alguna actividad, función o proceso con el fin de medirlas, analizarlas y comparar los productos, servicios y prácticas de la organización frente al líder reconocido en el área estudiada.

| Robert C. Camp (1989) | Es la búsqueda de las mejores prácticas de la industria que conducen a un desempeño excelente. |

| Bengt Kallöf y Svante Östblom (1993). | Es un proceso sistemático y continuo para comparar nuestra propia eficiencia en términos de productividad, calidad y prácticas con aquellas compañías y organizaciones líderes en excelencia. |

| Michael J. Spendolini (1994) | Un proceso sistemático y continuo para evaluar los productos, servicios y procesos de trabajo de las organizaciones que son reconocidas como representantes de las mejores prácticas, con el propósito de realizar mejoras organizacionales. |

| Benchmarking (2002) | Es un proceso abierto, dinámico y adaptable a todas las funciones del negocio. Es un proceso continuo de medir nuestros productos, servicios y prácticas contra el competidor más fuerte ó contra aquellas compañías reconocidas como líderes |

| Boxwell (1994, pp. 13–19) |

Proponerse metas utilizando normas externas y objetivas, y aprendiendo de los otros, y aprendiendo cuánto y cómo. |

El Benchmarking presenta, según Eccles (1991, p. 133), dos características: Primera, da a la dirección una metodología que puede ser aplicada con cualquier medida, financiera o no financiera. Segunda, ha propiciado un efecto transformador sobre los directivos en cuanto a sus perspectivas y actitudes deseadas. A este respecto, Álvarez y Blanco (1993, p. 778) subrayan que el uso de benchmarking implica "buscar la mejor performance dentro o fuera de la empresa y estudiarla para determinar por qué es la mejor y cómo se consigue, a fin de aplicarlo su propia compañía".

Esta técnica se utiliza tanto en el ámbito estratégico, para determinar los estándares de rendimiento, como en el ámbito operativo, para comprender mejor las prácticas y procesos que conducen a la consecución de rendimientos superiores. El objetivo que se persigue es lograr la superioridad en todas las áreas: calidad, fiabilidad del producto y coste. Para el benchmarking la implicación del personal tiene un papel clave en la solución de problemas del negocio, ya que, la implicación del personal asegura que el talento de las personas ejerza influencia sobre el negocio y los problemas laborales para lograr el éxito.

El proceso para aplicar elBenchmarking según Camp (1998, pp. 10–20) y Spendolini. (1992) consta de cinco fases:

I.- Fase de Planeación: Identificar qué se va a someter a benchmarking, y determinar el método para recopilación de datos. Los pasos esenciales son, qué, quién y cómo

II. Fase de análisis: recopilación y análisis de los datos. Comprensión de las prácticas de los socios del benchmarking y proyectar los niveles de actuación futuros.

III. Integración: Utilizar los hallazgos de benchmarking para fijar objetivos operacionales para el cambio. Comunicar los hallazgos de benchmarking y establecer metas funcionales.

IV. Acción: convertir en acción los hallazgos de benchmarking desarrollando planes de acción e implementando acciones específicas y supervisar el progreso.

V. Madurez: incorporar las mejores prácticas de la industria a todos los procesos del negocio, asegurando así la superioridad.

Existen varios tipos de benchmarking, según con los socios con los que se realiza. Así los podemos clasificar como Álvarez y Blanco (1993, p. 778), (Kraft,1997) y (Heras 2000):

Benchmarking de actividades internas: se trata de comparar las operaciones internas de la unidad de negocio que mejor performance tiene con todas las demás, con el fin de imitar al mejor. En la tabla nº 13 podemos ves las ventajas y desventajas del benchmarking interno.

| Tabla nº 13 Ventajas y desventajas del benchmarking interno | |

| VENTAJAS | INCONVENIENTES |

| El más eficiente en costes | Incentiva la mediocridad |

| Relativamente sencillo | Limita las opciones de crecimiento |

| Bajo coste | Bajo rendimiento |

| Conocimiento más profundo de la propia empresa | Puede crear una atmósfera no cooperativa dentro de la empresa |

| Distribución de la información | Posibilidad de degeneración interna |

| Fácil de aplicar lo aprendido | No suele ser contra el mejor |

| Rápido | No es un reto |

| Un buen punto de arranque | |

Benchmarking competitivo: La comparación se realiza entre competidores y con las mejores empresas, con la intención de comprender y aprender de ellos. Permite conocer mejor a nuestra competencia, aplicar las mejores prácticas a problemas comunes que afecten a la sociedad. En la tabla nº 14 podemos ver las ventajas y desventajas del benchmarking competitivo

| Tabla nº 14 ventajas y desventajas del benchmarking competitivo | |

| VENTAJAS | INCONVENIENTES |

| Comparar procesos comunes | Puede facilitarse información falsa o anticuada |

| Cooperación entre empresas | Secretos industriales |

| Problemática común | La competencia puede aprovechar tu debilidad |

| Problemas legales | |

| Rendimiento del 20% aproximadamente | |

Benchmarking funcional: permite compararnos con las mejores prácticas en áreas relacionadas, sean de la empresa que sean. Realiza el análisis de procesos similares dentro de un mismo sector y entre compañías que no compiten directamente un ejemplo que se dio en nuestra comunidad fue el de una naviera y una empresa de fabricación de trenes. En la tabla 15 mostramos las ventajas e inconvenientes de este tipo de benchmarking

| Tabla nº 15 ventajas e inconvenientes del benchmarking funcionnal | |

| VENTAJAS | INCONVENIENTES |

| Comparaciones cuantitativas | Distintas culturas empresariales |

| Muchas prácticas comunes en sectores diferentes | Necesita ser muy específica |

| Mayor mejora. Sobre el 35% | Requiere mucho tiempo |

| Mayor facilidad de acceso que en la competitiva | Necesita adaptación elevada |

Benchmarking genérico: Se centra en la innovación y se acerca los procesos excelentes empleados por otras compañías. Se trata de comparar procesos iguales con independencia del sector. Como ejemplo podemos citar el efectuado en 1992 por el First National Bank de Chicago con 14 compañías de diferentes sectores como, servicios, manufacturero, fotocopiadoras, productos de consumo, farmacéuticas, etc. (Heras 2000 261-277). En la tabla nº 16 podemos ver ventajas e inconvenientes del benchmarking genérico

| Tabla nº 16 ventajas e inconvenientes del benchmarking genérico | |

| VENTAJAS | INCONVENIENTES |

| No es una "amenaza" para la otra empresa | Alto coste |

| Innovación | Difícil |

| Alta mejora. | Mucho tiempo |

| Nueva perspectiva a problemas conocidos | Alto riesgo de fracaso |

Mallo y Merlo (1995, pp. 67-68) proponen una clasificación por su funcionamiento con dos enfoques: el benchmarking conducido por el coste y el benchmarking conducido por los procesos.

En el Benchmarking conducido por el coste se compara a la empresa con los competidores, teniendo como finalidad la reducción de costes.

En cuanto al Benchmarking conducido por los procesos la comparación, no se hace entre competidores sino entre socios y no se basa en la reducción de costes sino en la filosofía de mejora continua; si bien esta situación se traducirá inevitablemente en rendimientos superiores y como consecuencia, en reducciones significativas de costes.

Para nosotros el benchmarking es más que una simple comparación de las prácticas de una empresa frente a las de otra con el fin de mejorarlas. El benchmarking es una poderosa herramienta de decisión basada en datos reales, y dado que el estado de perfección no es eterno y las prácticas de los mejores cambian con el tiempo, nos obliga a un proceso de mejora continua. El benchmarking es de gran ayuda para empresas que tienen grandes costes de calidad y pretenden establecer objetivos en base al conocimiento de lo alcanzado por otros. El objetivo no es sólo alcanzar las mejores prácticas sino superarlas.

4.4.3. los círculos de calidad

Los Círculos de Calidad son el resultado de las investigaciones llevadas a cabo en el área humanística de Maslow (1943, pp. 370-396), McGregor (1969, pp. 33-40) y Hersberg (1959, pp. 45-48), así como de las técnicas desarrolladas por los doctores Deming (1966, pp. 56–59 ) y Juran (1974) y que el profesor Ishikawa (1986, pp. 65 -69) concretó hacia 1961 en el Japón .

Los Círculos de Calidad tuvieron su origen en el Japón en 1962 (Peiró y González 1993, p. 10), y se extendieron en dicho país hasta constituir un sistema altamente desarrollado por las compañías japonesas. Un círculo era un grupo reducido de personas, que realizaban trabajos similares y se reunían al menos una vez por semana para hablar de su trabajo, identificar problemas y proponer posibles soluciones.

El objetivo de los círculos de calidad es lograr incorporar a los trabajadores voluntariamente a un movimiento productivo en el que se esfuercen en hacer mejor su trabajo con sus compañeros y optimicen los recursos que manejan (Han 1984, pp. 84-85).

Sus sistemas de trabajo se encuentran normalizados para toda la compañía. Este esquema permite involucrar a la gerencia en la optimización de las mejoras desarrolladas por los grupos operativos. También orienta a los jefes de área, y líderes en las funciones y responsabilidades con lo que se logra desarrollar un progreso (Hutchins, 1981, 1985).

El análisis de los resultados y el número de progresos obtenidos muestra factores que no se pueden controlar sin la ayuda de los jefes de área, éstos son (Robson 1982; 1984):

· Facilitar el tiempo de reunión de los círculos. No permitir aplazar reuniones por exceso de trabajo.

· Motivar a los líderes desanimados.

· Facilitar los recursos en la ejecución de las mejoras.

En los círculos de calidad el sistema parte del principio de que quien mejor conoce el trabajo es quien lo realiza y por lo tanto es quien lo puede optimizar. Los círculos de calidad se concentran en una sola área con trabajadores de la misma y con sus propios problemas; esto les permite entender a todos la naturaleza del problema, actitud que facilita el planteamiento de soluciones factibles (Mohr y Mohr 1983; Hutchins, 1985). Como son los trabajadores mismos los encargados de llevarlo a la práctica, se aseguran que sus ideas alcancen el éxito y, por lo tanto, tienen el orgullo de ser ellos mismos quienes lograron la solución .

Los círculos de calidad persiguen los siguientes objetivos Mohr y Mohr, 1983; Pickler, 1983, pp. 82-89, 1983; Rieker, 1979, pp. 989- 984 Shaw, 1981, pp. 24 – 29 ):

· Reducir los errores y los costes y aumentar la calidad.

· Generar más efectividad en los resultados.

· Promover el involucramiento en el trabajo.

· Incrementar la motivación.

· Crear una actitud para prevenir problemas.

· Crear la capacidad de resolver problemas.

· Mejorar la comunicación.

· Mejorar las relaciones entre jefes y subordinados.

· Establecer un genuino ambiente de higiene y seguridad.

· Reducción de tiempos muertos.

· Reducción de absentismo.

· Desarrollo como persona.

4.4.4. Seis sombreros para pensar

Se trata de una técnica de creatividad para la de resolución de problemas en la cual se discute ordenadamente sobre la adopción de una decisión determinada (Escorsa y Valls 1997 p. 101). Cuando se está pensando se suele tratar de hacer mucho al mismo tiempo y se termina siendo confuso e ineficaz. Esta herramienta describe un camino sencillo pero efectivo para convertirse en mejor pensador.

Separa el pensamiento en seis modos distintos, que identifica como "seis sombreros para pensar". Al ponerse un sombrero puede centrar y enfocar el pensamiento. Si cambia de sombrero puede redirigir el pensamiento (Edward De Bono 1991, 1996, pp. 45-49). Durante la reunión, de una forma simbólica, los asistentes utilizan consecutivamente seis sombreros con colores diferentes. Cada color tiene asociada una actitud. De esta forma se consigue tratar un tema de una forma exhaustiva y evitar las discusiones estériles, acortando la duración de las reuniones. Sirve para elevar el nivel de integración y, por consiguiente, el de comunicación y colaboración.

Este método puede incorporar pensamiento lateral. Los seis sombreros se deben considerar como direcciones de pensamiento más que etiquetas para el pensamiento. Esto quiere decir que los sombreros se utilizan proactivamente y no reactivamente (De Bono (1991).

El pensamiento con el sombrero blanco. tiene que ver con hechos, cifras, necesidades y ausencias de información significa: argumentos, propuestas, datos y cifras.

El pensamiento con el sombrero rojo tiene que ver con la intuición, los sentimientos y las emociones. El sombrero rojo le permite al participante exponer una intuición sin tener que justificarla.

Pensamiento con el sombrero negro. Es el sombrero del juicio y la cautela. En ningún sentido es un sombrero negativo o inferior a los demás. El sombrero negro se utiliza para señalar por qué una sugerencia no encaja en los hechos, la experiencia disponible, el sistema utilizado o la política que se está siguiendo. El sombrero negro debe ser siempre lógico.

Pensamiento con el Sombrero Amarillo tiene que ver con la lógica positiva. Por qué algo va a funcionar y por qué ofrecerá beneficios. Debe ser utilizado para mirar adelante hacia los resultados de una acción propuesta, pero también puede utilizarse para encontrar algo de valor en lo que ya ha ocurrido.

Pensamiento con el sombrero verde. Es el sombrero de la creatividad, alternativas, propuestas, lo que es interesante, estímulos y cambios.

Pensamiento con el sombrero azul. Es le sombrero de la vista global y del control del proceso. No se enfoca en el asunto propiamente dicho sino en el "pensamiento" acerca del asunto.